乌托邦的捷径:AI治理“失败国家”的可行性分析与伦理困境

一、失败国家的核心特征与治理困境

根据国际权威评估体系(如《失败国家指数》),失败国家通常呈现以下特征:

- 政治失效:政府丧失对领土的控制力,法治崩溃,腐败横行(如索马里长期无政府状态,阿富汗塔利班政权缺乏国际认可)。

- 经济崩溃:过度依赖单一资源(如南苏丹的石油、海地的矿产),但资源分配被权贵垄断,经济多元化失败。

- 社会撕裂:民族、宗教冲突频发(如叙利亚内战、缅甸罗兴亚人危机),公共服务(教育、医疗)几乎瘫痪。

- 安全失控:恐怖组织或军阀割据(如索马里“青年党”、也门胡塞武装),暴力事件成为常态。

传统治理手段(如国际援助、军事干预)往往陷入“越扶越贫”的怪圈。例如,美国在阿富汗投入2万亿美元,最终因腐败和治理失效导致政权崩溃。

二、AI治理的技术优势与潜在应用场景

AI在治理领域展现出的独特优势,为失败国家提供了理论上的解决方案:

数据驱动决策:

- 案例:安徽电信的“平安社区”系统通过AI分析监控画面,实时预警人群聚集、火情等风险,将治安事件消除在萌芽阶段。此类技术可应用于失败国家的公共安全领域。

- 扩展:AI可整合经济数据(如资源分布、失业率),动态优化资源分配,避免人为贪污(如索马里援助资金被军阀截留)。

算法透明与公平:

- 司法领域:AI法官基于历史案例和法律条文进行判决,减少腐败和人情干预(日本已尝试AI辅助政策评估)。

- 立法模拟:通过AI模拟不同法律对社会的影响,选择最优法制框架(如新加坡用AI优化城市规划)。

资源高效配置:

- 应急管理:AI可快速响应自然灾害(如地震、洪水),协调救援资源,避免官僚延迟。

- 基础设施:沙特NEOM未来城计划通过AI管理能源、交通,实现零碳排放,此类模式可复制到资源丰富但治理薄弱的国家。

三、AI治理的伦理争议与现实风险

尽管技术优势显著,AI治理仍面临多重挑战:

伦理困境:

- 算法偏见:AI可能继承历史数据中的偏见(如招聘系统倾向男性),加剧社会不公。

- 责任归属:AI决策失误时,开发者、使用者责任难以界定(如自动驾驶事故的法律责任划分)。

现实风险:

- 技术依赖:过度依赖AI可能导致人类治理能力退化(如基层执法者丧失现场判断力)。

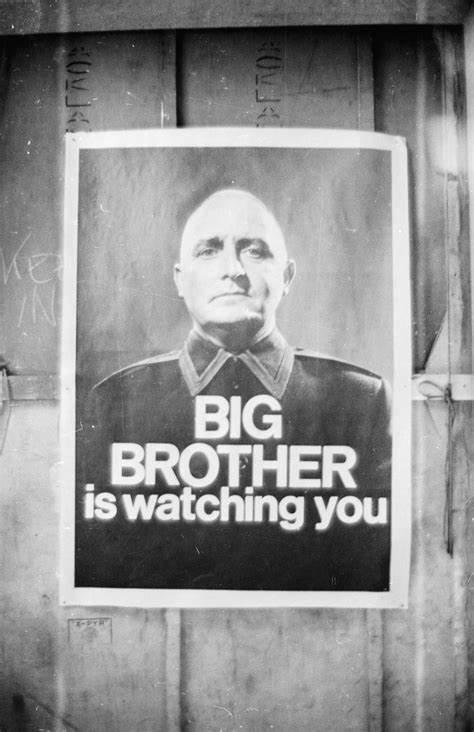

- 主权争议:AI治理可能被视为“技术殖民”,引发国际干预争议(如联合国反对外部强制技术干预)。

- 社会接受度:民众可能抵制“非人类”决策者(如AI法官缺乏人情味,难以处理复杂社会矛盾)。

数据与算力限制:

- 失败国家往往数据基础薄弱,AI训练所需的高质量数据难以获取。

- 高昂的算力成本(如沙特NEOM城预算超5000亿美元)超出这些国家的财政承受能力。

四、可行性评估与乌托邦悖论

短期可行性:

- 垂直领域应用:AI在监控、资源分配等单一场景已有效,但复杂决策(如冲突调解)仍需人类介入。

- 成本效益:初期投入高,但长期可降低腐败成本(如减少贪污、提高资源效率)。

长期挑战:

- 制度适配性:AI需嵌入现有法律框架,但失败国家法律体系往往已崩溃。

- 文化适应性:AI决策可能忽视当地文化习俗(如土地分配中的部落传统)。

乌托邦悖论:

- 理想与现实差距:AI治理假设“技术中性”,但实际受制于数据质量与算法设计者的价值观。

- 权力真空风险:AI取代政府后,可能形成新的技术寡头(如科技巨头掌控基础设施)。

五、替代路径与建议

混合治理模式:

- AI辅助,人类决策:AI负责数据收集与分析,人类决策者进行最终判断(如新加坡的“AI顾问+人类市长”模式)。

- 国际共建机制:通过联合国框架,由多国技术团队共同开发AI系统,避免单一国家主导。

试点推广:

- 选择试点国家:优先选择资源丰富但治理薄弱的国家(如南苏丹),解决公共服务(医疗、教育)问题。

- 逐步扩展:从单一场景(如公共安全)向复杂领域(如司法、立法)过渡。

伦理与监管:

- 国际标准:参考联合国教科文组织的《人工智能伦理问题建议书》,建立全球治理准则。

- 透明度要求:强制AI系统公开算法逻辑,接受第三方审计(如欧盟《AI法案》要求高风险系统备案)。

六、结论

AI治理为失败国家提供了一条技术驱动的“捷径”,但其可行性受限于伦理、文化、经济等多重因素。短期内,AI可作为辅助工具提升效率,但无法替代人类在政治协商、文化调解中的核心作用。长期来看,需通过混合治理模式、国际共建机制和伦理监管,逐步构建“技术向善”的治理框架。乌托邦的实现,最终取决于人类能否在技术进步与人文关怀之间找到平衡。